Films over kunstmatige intelligentie: maak je eigen video

U leest de nieuwsbrief van Natuurlijk Intelligent vanaf 11 juli 2024. Wilt u de nieuwsbrief elke tweede donderdag per e-mail ontvangen, meld u dan hier aan.

Herinner je je de vrouw die door Tokio liep? leuk vinden OpenAI Toen hij in februari zijn AI Sora-video introduceerde, waren internet en ik verbaasd over hoe realistisch de weerspiegeling van kunstmatige schoenen met hoge hakken op de helder verlichte vijvers in de binnenstad was.

Volgens OpenAI is de video alleen gemaakt met een korte tekstopdracht, maar lijkt deze gefilmd te zijn. Dit was beter dan alles wat AI-systemen tot dan toe hadden kunnen produceren. Maar het was slechts een voorbeeldvideo. Tot op de dag van vandaag, vijf maanden later, is Sora niet beschikbaar voor het publiek.

Sinds vorige week is echter het eerste concurrerende product publiekelijk verkrijgbaar, wat minstens even goede resultaten oplevert. Het komt van de New Yorkse startup Runway en heet Gen-3.

Voor wie een abonnement heeft Programmering Als het klaar is, kan het video’s maken van maximaal tien seconden met behulp van tekstprompts. De resultaten zijn niet perfect, maar ze zijn interessant genoeg om mee te experimenteren terwijl je toch iets nieuws probeert om te zien wat Runway ermee creëert.

Toen OpenAI afgelopen februari Sora introduceerde, voerde ik een experiment uit: ik voerde een aantal commando’s in die OpenAI zei te gebruiken voor Sora-demovideo’s en vergeleek ze met de resultaten van Runway. Zelfs toen beschikte Runway al over zogenaamde kunstmatige intelligentie om tekst naar video om te zetten. Dit eerdere Gen-2-model leverde echter veel slechtere resultaten op dan de Sora. Een gemaakte mammoet veranderde bijvoorbeeld in de loop van een paar seconden van de video in een bruine massa.

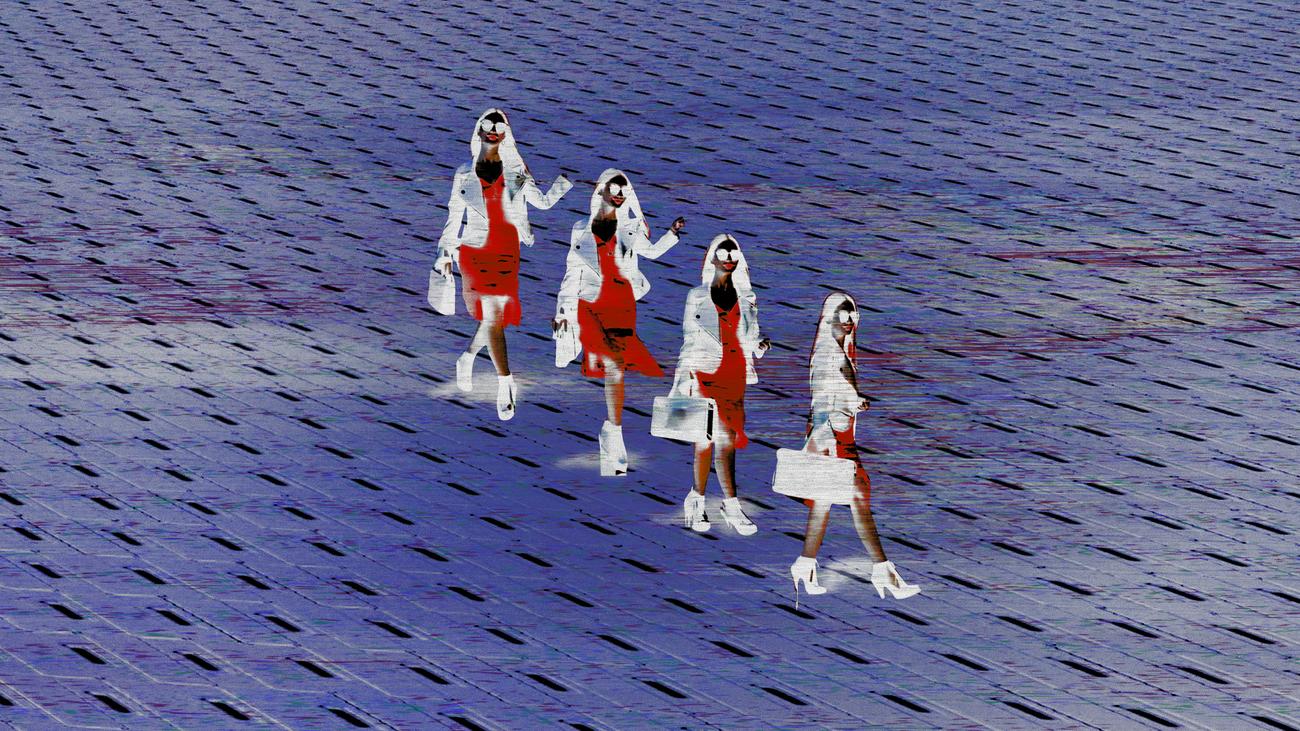

Ik heb het experiment nu herhaald en ik moet zeggen: video’s die nu met Gen-3 zijn gemaakt, kunnen het bijhouden. Hier zie je een screenshot van een video gemaakt met Runway. Je kunt de volledige video bekijken via deze link. Voorbeeldvideo van Sora met hetzelfde idee Je vindt het hier.

Screenshot van AI-video. Prompt: “Een elegante vrouw loopt door een straat in Tokio vol warme, gloeiende neon- en geanimeerde stadsborden. Ze draagt een zwart leren jasje, een lange rode jurk, zwarte schoenen en een zwarte tas. Ze draagt een zonnebril en rode lippenstift. Ze loopt zelfverzekerd en nonchalant. De straat is vochtig en reflecterend, waardoor een spiegeleffect van kleurrijke lichten ontstaat.

© Gemaakt door Runway door Jakob von Lindern voor ZEIT ONLINE

Toegegeven, de video van Runway’s Woman in Tokyo is niet zo verbazingwekkend gedetailleerd als die van Sora. Maar de AI voert de instructies nauwkeurig uit en de lichtreflecties op de grond zijn sfeervol – en behoorlijk realistisch. Bij nader inzien zijn de benen van de vrouw op een gegeven moment onnatuurlijk in elkaar verstrengeld, maar op een gegeven moment gebeurt er iets soortgelijks, zelfs in Sora’s video.

Aangenomen mag worden dat de demovideo’s van OpenAI de beste van vele pogingen zijn, omdat de resultaten van deze AI-systemen vaak niet bijzonder voorspelbaar zijn. Het valt niet uit te sluiten dat Runway na meerdere runs met vrijwel perfecte versies van de betreffende video’s op de proppen komt.

Net als op andere gebieden van de kunstmatige intelligentie is er nu sprake van een soort commoditisering. Wat aanvankelijk een baanbrekende sensatie was, is nu sinds een paar maanden min of meer voor iedereen (betalende Runway-klanten) beschikbaar.

Iedereen die een jaar geleden probeerde een op tekst gebaseerde video te maken, werd teleurgesteld door de pixelbrij. Een video van de vrouw in Tokio, die vandaag geproduceerd zou kunnen worden, zou op zijn minst als schets kunnen dienen. Met een beetje postproductie kunnen deze clips ook voor commercials worden gebruikt. En over een jaar? Over vijf? Zijn er hele films via tekstcommando’s?

Runway-CEO Cristobal Valenzuela vergelijkt In een podcastinterview Kunstmatige intelligentie creëerde video’s met de uitvinding van de camera. Hij zegt in deze analogie dat we ons in een situatie bevinden als het eerste decennium van de twintigste eeuw. De camera werkte, maar hij werd alleen in zwart-wit opgenomen en bijna niemand wist wat hij ermee moest doen. Maar Hollywood kwam kort daarna.

Als dit waar is? Je moet oppassen dat je niet snel aanneemt dat de toekomst al bestaat, alleen maar omdat de eerste tekenen erop wijzen dat dit mogelijk is. Maar je moet niet de fout maken om technologie na de eerste moeilijke pogingen als nutteloos af te schrijven. Immers: met Runway Gen-3 kan iedereen nu zijn eigen foto’s maken – of beter gezegd, video.

Links voor verder lezen

- In zijn nieuwsbrief beschrijft economieprofessor Ethan Mollick hoe technologieën – digitale camera’s en misschien video-AI – in kleine stapjes verbeteren totdat ze een drempel van bruikbaarheid overschrijden: “Geleidelijk, dan plotseling: op de drempel” (Eén nuttig ding)

- Runway-oprichter Cristóbal Valenzuela stelt zich een wereld voor waarin gepersonaliseerde verhalen rechtstreeks worden gecreëerd voor degenen die kijken of spelen. Hij schrijft in dit bericht.

- Er staan ook hele coole video’s van de Runway Gen-3 online. Sommigen daarvan bijvoorbeeld op het X-account van videokunstenaar Sway Molina.

Denk aan kunstmatige intelligentie

- Iedereen heeft het over Nvidia-chipsets, ook omdat het bedrijf zeer populaire software voor AI-programmering aanbiedt. De Finse startup Silo AI heeft een trainingssysteem ontwikkeld voor processors van rivaliserende AMD – en AMD heeft het nu gekocht. “AMD koopt toonaangevend Europees AI-bedrijf voor $665 miljoen” (Handelsblatt)

- Ray Kurzweil werd beroemd omdat hij de Singularity voorspelde, een toestand waarin kunstmatige intelligentie zichzelf steeds intelligenter kon maken en mensen onsterfelijk kon maken. Hij gelooft dat we daar dichter bij zijn. “Ray Kurzweil zegt nog steeds dat hij AI zal samenvoegen” (New York Times)

- Uiteindelijk gaat het om geld, ook bij AI. Tot nu toe heeft de technologie “bijna geen economische impact” gehad, zo blijkt uit macro-economische gegevens: “Wat is er met de AI-revolutie gebeurd?” (De econoom)

- Dit keer nieuw advies in deze fase. Mark Uwe Kling, auteur van The Kangaroo Chronicles, heeft een spannend verhaal geschreven. Zonder al te veel weg te geven: als deze nieuwsbrief u interesseert, misschien ook dit boek: Keer bekeken (Olstein)

Spelen met kunstmatige intelligentie

- Met deze AI-taal van een Parijse startup kun je vloeiend spreken. Inhoudelijk valt er niet veel te eten, maar onderbroken worden door een chatbot is een nieuw gevoel: https://moshi.chat/?queue_id=talktomoshi.

- Nog een AI-video om te proberen. Voormalige medewerkers van DeepMind introduceerden Haiper, dat clips van vier seconden produceert: https://haiper.ai/.

- Stilstaande beelden mogen niet verloren gaan in de hele video. Stable Diffusion 3 is al een tijdje beschikbaar – en bovendien drie dagen gratis: https://stability.ai/stable-assistant.

U leest de nieuwsbrief van Natuurlijk Intelligent vanaf 11 juli 2024. Wilt u de nieuwsbrief elke tweede donderdag per e-mail ontvangen, meld u dan hier aan.

Herinner je je de vrouw die door Tokio liep? leuk vinden OpenAI Toen hij in februari zijn AI Sora-video introduceerde, waren internet en ik verbaasd over hoe realistisch de weerspiegeling van kunstmatige schoenen met hoge hakken op de helder verlichte vijvers in de binnenstad was.

Volgens OpenAI is de video alleen gemaakt met een korte tekstopdracht, maar lijkt deze gefilmd te zijn. Dit was beter dan alles wat AI-systemen tot dan toe hadden kunnen produceren. Maar het was slechts een voorbeeldvideo. Tot op de dag van vandaag, vijf maanden later, is Sora niet beschikbaar voor het publiek.

“Coffee fanatic. Gamer. Award-winning zombie aficionado. College student. Hardcore internet proponent. Twitter guru. Subtly charming bacon nerd. Thinker.”